(1.1)

Учреждение Российской академии наук

Санкт-Петербургский

институт информатики и автоматизации РАН

На правах рукописи

Крижановский Андрей Анатольевич

Математическое и программное

обеспечение

построения списков семантически близких слов

на

основе рейтинга вики-текстов

Специальность: 05.13.11: «Математическое и программное обеспечение вычислительных машин, комплексов и компьютерных сетей»

Диссертация на соискание учёной степени

кандидата технических наук

Научный руководитель

д.т.н. проф. А.В. Смирнов

Санкт-Петербург

2008

Оглавление

Введение 5

Положения, выносимые на защиту. 19

1. Анализ проблемы автоматической обработки текста и поиска семантически близких слов 20

Проблема синонимии 20

1.1 Основные алгоритмы поиска похожих интернет страниц, поиска слов близких по значению, вычисления меры сходства вершин графа 26

Алгоритмы анализа гиперссылок: HITS, PageRank, ArcRank, WLVM 27

Алгоритмы построения и анализа ссылок: Similarity Flooding, алгоритм извлечения синонимов из толкового словаря и другие 31

Алгоритмы статистического анализа текста: ESA, поиск контекстно-связанных слов 34

Метрики 36

1.2 Системы и ресурсы для обработки текста 42

GATE 42

Проект Диалинг 44

Тезаурусы WordNet, РуТез, Викисловарь 45

Вики-ресурсы 51

Корпус текстов вики-ресурса Википедия 53

Другие системы 55

1.3 Системы и способы графического представления тезаурусов и результатов поиска 56

1.4 Постановка задачи исследования 62

Выводы по главе 1 64

2. Методологическое и математическое обеспечение для построения списков семантически близких слов в корпусе текстовых документов с гиперссылками и категориями 66

2.1 Подход к поиску семантически близких слов 66

2.2 HITS алгоритм (формализация, анализ, поиск синонимов) 69

Формализация задачи 69

Дополнительные замечания 71

Тематическая связность авторитетных страниц 73

Применение способов оценки результатов поиска в Интернет к HITS алгоритму 73

Поиск синонимов с помощью HITS алгоритма 74

2.3 Адаптированный HITS алгоритм, включающий алгоритм иерархической кластеризации 76

Формализация понятия «похожие вершины» графа 76

Адаптированный HITS алгоритм 77

Кластеризация на основе категорий статей 81

Варианты объединения результатов АHITS алгоритма и алгоритма кластеризации 85

Временная сложность алгоритма 85

Эвристика: фильтрация на основе категорий статей 86

2.4 Вычисление меры сходства вершин графа. Оценка временной сложности. Эвристики 86

Задача поиска похожих вершин графа. 87

Алгоритм поиска похожих вершин графа 88

Оценка временной сложности 89

Эвристики 89

2.5 Показатели численной оценки семантической близости списка слов 91

Коэффициент Спирмена 92

Выводы по главе 2 94

3. Организация программного обеспечения поиска семантически близких слов, автоматической оценки поиска и морфологического анализа слов 96

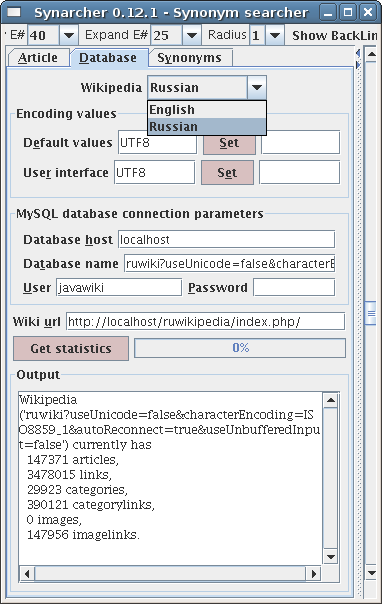

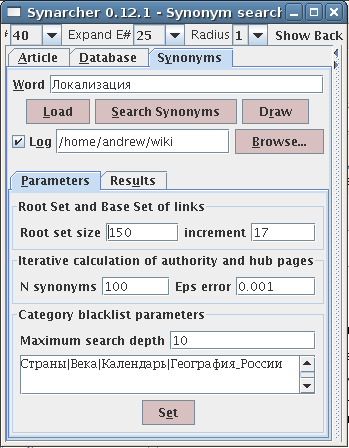

3.1 Архитектура программной системы Synarcher 96

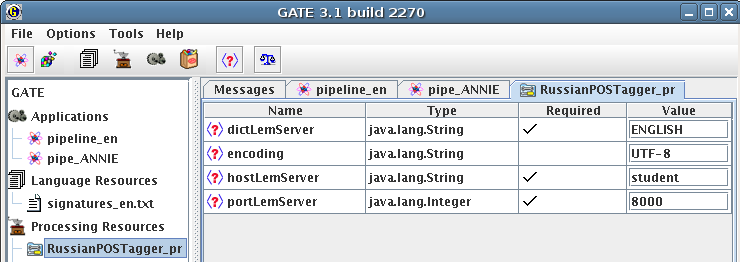

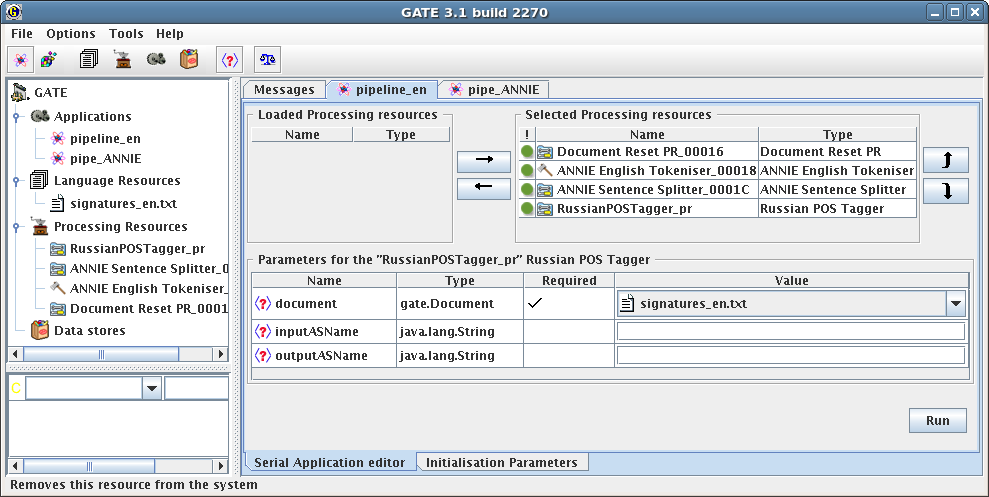

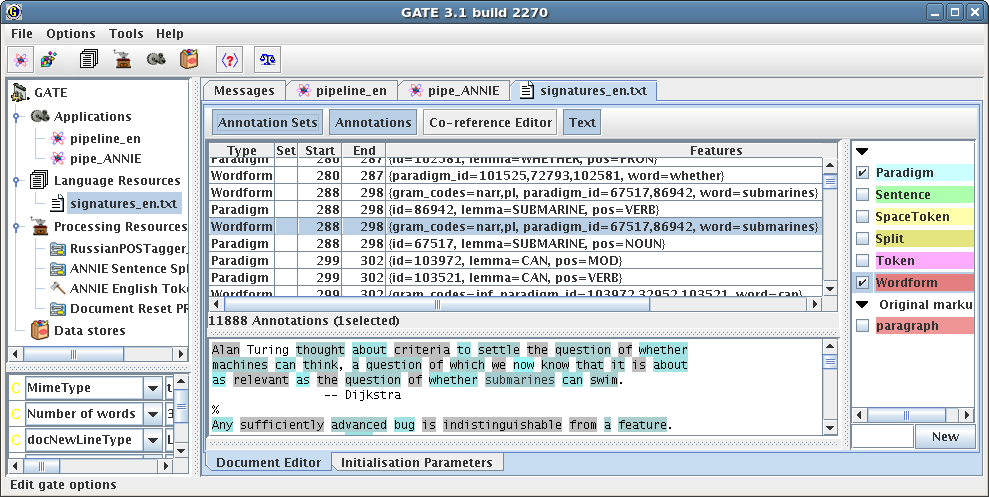

3.2 Архитектура подсистемы GATE для удалённого доступа (на основе XML-RPC протокола) к программе морфологического анализа Lemmatizer 106

3.3 Индексирование вики-текстов: архитектура системы и структура индексной базы данных 108

Архитектура системы построения индексной БД вики-текстов 109

Таблицы и отношения в индексной БД 111

3.4 Архитектура программной системы для автоматической оценки списков семантически близких слов 113

Выводы по главе 3 115

4. Эксперименты и практическое использование разработанных в диссертации алгоритмов 117

4.1 Экспериментальная оценка работы адаптированного HITS алгоритма 117

Оценка тестируемого корпуса текстов 117

Эксперименты с Английской Википедией 118

Эксперименты с Русской Википедией 120

Экспериментальное сравнение адаптированного с исходным HITS алгоритмом 122

Сравнение результатов работы AHITS алгоритма с другими на основе 353 пар английских слов 127

Пример оценки эвристики с помощью коэффициента Спирмена 131

Применение коэффициента Спирмена для оценки параметров адаптированного HITS алгоритма 132

4.2 Сессия нормализации слов на основе модуля Russian POS Tagger, как одного из этапов автоматической обработки текстов в системе GATE 135

4.3 Индексирование вики-текста: инструментарий и эксперименты 138

Преобразование вики-текста с помощью регулярных выражений 138

API индексной базы данных вики 142

Эксперименты по построению индексных баз данных 143

Проверка выполнения закона Ципфа для вики-текстов 145

4.4 Эксперименты в проекте «Контекстно-зависимый поиск документов в проблемно-ориентированных корпусах» 148

Выводы по главе 4 153

Заключение 155

Список источников литературы 157

Приложение 1. Список наиболее употребительных сокращений 176

Приложение 2. Акты внедрения 177

Приложение 3. Экспериментальные данные программы Synarcher 180

Приложение 4. Упорядочение списков с помощью респондентов 182

Приложение 5. Википедия 183

Отношения в Википедии 183

Замечания о категориях и ссылках Википедии 186

Некоторые определения. Для более ясного понимания материала и во избежание недоразумений целесообразно привести следующие определения.

Тезаурус – это словарь, в котором слова, относящиеся к каким-либо областям знания, расположены по тематическому принципу и показаны семантические отношения (родо-видовые, синонимические и др.) между лексическими единицами.1

Глоссарий – это собрание глосс (толкований) непонятных слов или выражений с толкованием (толковый глоссарий) или переводом на другой язык (переводной глоссарий).2

Информационные поисковые системы (ИПС) – системы поиска релевантных3 документов (текст, изображение, аудио, видео файлы и др.) в сети Интернет или на локальном компьютере, где задача формулируется пользователем в виде набора ключевых слов с возможностью их объединения логическими правилами (И, ИЛИ и др.).

Актуальность темы диссертации. Увеличение числа и изменение качества4 электронных документов на локальных компьютерах и в сети Интернет требуют новых алгоритмов для более точного и быстрого поиска.

Выделяют два вида сходства [179]: сходство между объектами (рассматривается в данной работе) и сходство между отношениями (relational similarity, см. [178], [177], [180])5. Является ли сущность свойством объекта или отношением – определяется контекстом [105]. Поиск похожих объектов (similarity search) включает такие (на первый взгляд разные, но общие по способам решения) задачи, как поиск похожих текстовых документов, поиск семантически близких слов, поиск похожих вершин графа. Анализ работ в области вычислительной лингвистики показал большое разнообразие алгоритмов, предлагающих решение этих задач (алгоритм HITS [125], алгоритм PageRank [85] (и его модификация Green [145]), алгоритм распределения рангов ArcRank [174], ESA [103], алгоритм извлечения синонимов из толкового словаря [174], метод извлечения контекстно связанных слов [122], [146] и др.). Поиск похожих документов также может являться подэтапом алгоритма поиска документов по запросу [22].

Объектом исследования является синонимия и семантическая близость слов. Два текста связаны гиперссылкой, если один документ упоминает ( то есть ссылается на) другой текст. Тематическая направленность каждого текста определена экспертом, который присваивает одну или несколько категорий тексту1.

Под семантически близкими словами подразумеваются слова с близким значением, встречающиеся в одном контексте. Более строго и формально семантически близкие слова определяются ниже через понятия авторитетных и хаб-страниц2. Представляемая в работе программная система поиска семантически близких слов относится к семантическим3, поскольку лингвосемантические отношения рассматриваются на уровне текста, а также учитываются сведения о данной предметной области.

Современные алгоритмы поиска синонимов (например, алгоритм извлечения синонимов из толкового словаря [174], алгоритм SimRank [119], алгоритм Similarity Flooding [132]) изначально предназначены для вычисления меры сходства между вершинами графов. Поэтому алгоритмы не учитывают такую дополнительную информацию, как тематическая направленность и метаданные текста [143], [93], [113]. Данная работа призвана восполнить этот пробел.

Требованием к выбору алгоритма (для поиска семантически близких слов) является возможность использования (в рамках алгоритма) тех дополнительных возможностей, которые предоставляет рассматриваемый корпус документов. Это (1) наличие категорий (классифицирующих документы по их тематической принадлежности)1, (2) наличие метаинформации в виде ключевых слов (в простейшем случае – это заголовок документа). Таким требованиям удовлетворяют алгоритмы HITS [125] и PageRank [85]. Для поиска семантически близких слов был выбран алгоритм HITS, а не PageRank по следующим причинам:

1) формулы вычисления в PageRank требуют экспериментального выбора коэффициента (damping factor)2, а в HITS нет никакого коэффициента за счёт использования двух типов документов (авторитетные и хаб).

2) значения весов (рассчитанные с помощью PageRank) не могут быть использованы напрямую для поиска похожих страниц. То есть нужен дополнительный алгоритм, который будет искать похожие страницы на основе весов PageRank.

Поиск документов на основе алгоритма HITS тесно связан с вычислением сходства вершин в графе. Автором предложены два способа вычисления меры сходства вершин графа на основе формализации понятия «похожие вершины» графа. Первый вариант использует понятия авторитетных и хаб-страниц и позволяет формализовать задачу поиска похожих страниц в HITS алгоритме. Во втором варианте получена формула сходства двух вершин a и b, основанная на поиске общих вершин среди соседей вершин a и b.

В данной работе представлены алгоритмы (адаптированный HITS алгоритм и оригинальный алгоритм вычисления меры сходства вершин графа) и реализация адаптированного HITS алгоритма в виде программной системы поиска семантически близких слов. Также спроектирована архитектура программной системы оценивания и разработаны способы численной оценки набора синонимов. Способы численной оценки набора синонимов необходимы для проведения экспериментальной части работы.

При выборе программных инструментальных средств разработки и проектирования архитектуры программы автор придерживался следующих требований: открытость исходного кода (open source), кроссплатформенность (возможность работы на разных платформах: Linux, Windows и др.), модульность архитектуры (возможность использовать предыдущие наработки и интегрировать решения разных подзадач). Важными требованиями были: использование достаточно широко распространённых и хорошо себя зарекомендовавших программных систем для обработки текста на естественном языке и представление результатов работы в виде текста и графики (визуализация). Использование общепринятого стандарта и модульность архитектуры позволяют решить задачу большой сложности (например, машинный перевод), разбив её на ряд подзадач. В качестве программной среды для обработки текстов на естественном языке была выбрана модульная система GATE [92], [98].

Сложность организации поиска семантически близких слов и, в частности, синонимов определяется рядом причин. Во-первых, автору не известно общепринятой количественной меры для определения степени синонимичности значений слов. Можно утверждать, что одна пара слов более синонимична чем другая, но не ясен способ, позволяющий однозначно указывать – во сколько раз.1 Во-вторых, понятие синонимии определено не для слов, а для значений слов, то есть синонимия неразрывно связана с контекстом. В-третьих, язык – это вечноизменяемая субстанция, открытая система. Слова могут устаревать или получать новые значения. Особенно активное словообразование и присвоение новых значений словам наблюдается в науке, в её молодых, активно развивающихся направлениях. Решение задачи поиска синонимов в частности (а также современных задач автоматизированной обработки текстов на естественном языке в целом) требуют предварительной морфологической обработки текста.

Отсутствуют (по крайней мере, неизвестны автору) доступные модули в системе GATE для морфологической обработки русского языка. Возможно, поэтому система GATE редко упоминается в системах обработки текстов на русском языке. Таким образом, существует насущная необходимость в наличии модуля морфологической обработки русского языка в системе GATE, позволяющая нормализовать слова (лемматизация2), получать морфологические признаки слова (например, род, падеж) и т. д. При этом существует общедоступная программа морфологической обработки русского Lemmatizer (разработанная в проекте Диалинг московскими учёными). Сложность в том, что GATE написан на языке программирования Java, а Lemmatizer написан на C++. Таким образом, решением данной задачи будет разработка архитектуры позволяющей интегрировать эти системы.

К задачам автоматической обработки текста (АОТ) относятся такие задачи, как: машинный перевод, поиск и хранение текста [52], кластеризация текстов1 [43], [70], определение тематически однородных частей текста и приписывание этим частям документа тематических тегов [72], [104], реферирование текстов, и многие др. Автоматический поиск синонимов и семантически близких слов является одной из задач АОТ.

Актуальность работы определяется возможными областями приложений результатов диссертации. Во-первых, это поиск похожих вершин графа в рамках задачи Ontology Matching [132], [164], [190]. Во-вторых, предложенное решение задачи автоматического поиска синонимов и семантически близких слов может использоваться в поисковых системах для расширения запроса (на основе вычисления сходства запроса и документа [86], сходства запросов между собой2 [101], с помощью тезаурусов [10], [95], [163]), для автоматизированного построения онтологии по тексту3, для расширения существующих и создания новых тезаурусов4 [135]. В-третьих, разработанная программа поиска семантически близких слов, вероятно, будет востребована лингвистами-лексикографами при составлении словарей синонимов [7], [56], [161]. В работе [79] перечислены ещё два приложения, требующих решения задачи «similarity search»:

«collaborative filtering» – определение пользователей, имеющих одинаковый вкус, предпочтения;

поиск / исключение документов почти-копий (англ. «near duplicate»), которое требуется при индексировании документов.

Ещё одна актуальная область связана с задачей определения значения многозначного слова1. Основа алгоритма представленного в [153], [187] – анализ контекста слова. При этом начальные слова2 в обучающем наборе (в алгоритме, предложенном в [187]) должны точно различать возможные значения. Выбор начальных слов (для заданного слова) можно выполнять с помощью предложенного в диссертации алгоритма поиска семантически близких слов. Другие актуальные направления новых информационных технологий, в которых могут использоваться результаты данной диссертационной работы – это направление запросно-ответных систем (question-answering system) и автоматическое создание проблемно-ориентированных тезаурусов3.

Данная диссертационная работа выполнена в рамках указанного направления исследований.

Цель работы и задачи исследования. Целью работы является решение задачи автоматизированного построения упорядоченного списка семантически близких слов в проблемно-ориентированных корпусах с гиперссылками и категориями (на примере корпуса текстов открытой энциклопедии Википедия) с возможностью оценки результатов поиска. Для достижения поставленной цели необходимо:

Проанализировать методы поиска семантически близких слов, обосновать выбор текстовых ресурсов, алгоритма (с возможной адаптацией) и программных систем для автоматической обработки текстов на естественном языке (ЕЯ).

Разработать подход к поиску семантически близких слов (в корпусе текстовых документов с гиперссылками и категориями).

Разработать алгоритмы поиска семантически близких слов в корпусе текстовых документов с гиперссылками и категориями.

Спроектировать и реализовать программный комплекс поиска семантически близких слов; разработать способы численной оценки наборов синонимов.

Методы исследования. Для решения поставленных задач в работе используются методы кластерного анализа [43], [70], методы теории графов [19], [28], [29], [38], [45], [46], [49], элементы теории сложности алгоритмов [5], [23], [32], [42], стандарты открытых информационных сред. При разработке программного обеспечения использовалась технология объектно-ориентированного программирования (Java, C++) [13], язык структурированных запросов (SQL) управления данными в реляционных базах данных [26], программная среда для обработки текстов на естественном языке (GATE) [92], [98].

Научная новизна

Новизна предложенного подхода к поиску семантически близких слов в проблемно-ориентированном корпусе заключается в том, что кроме гиперссылок дополнительно учитывается метаинформация документов (ключевые слова, категории).

Новизна адаптированного HITS алгоритма состоит в том, что при поиске наиболее похожих документов в корпусе учитываются не только гиперссылки, но и категории, что позволяет применить механизм иерархической кластеризации, объединяющий семантически близкие слова в смысловые группы.

Новый способ построения корневого набора документов в адаптированном HITS алгоритме заключается в выборе документов, связанных гиперссылками с исходным документом (заданным пользователем), что позволяет отказаться от шага «предварительный веб-поиск документов».

Коэффициент Спирмена модифицирован для численного сравнения списков семантически близких слов; отличие заключается в возможности сравнивать списки разной длины.

Впервые предложен показатель степени синонимичности набора слов, заключающийся в сравнении этого набора с эталонным списком синонимов (например из тезауруса).

Впервые спроектирована распределённая архитектура программного комплекса, позволяющего выполнять поиск семантически близких слов и оценивать результаты поиска на основе удалённого доступа к тезаурусам.

Эксперименты подтвердили выполнение закона Ципфа для текстов Русской Википедии и Википедии на английском упрощённом языке на основе построенных индексных баз данных.

Обоснованность и достоверность научных положений, основных выводов и результатов диссертации обеспечивается за счёт тщательного анализа состояния результатов исследований в области вычислительной лингвистики, подтверждается корректностью предложенных моделей, алгоритмов и согласованностью результатов, полученных при компьютерной реализации, а также проведением экспериментов с поиском семантически близких слов в корпусе текстов английской и русской версии энциклопедии Википедия.

Практическая ценность работы заключается в том, что реализованная программная система позволяет выполнять поиск семантически близких слов в английской и русской версии энциклопедии Википедия. Причём нет принципиальных ограничений в применении программы к Википедия на других языках, к вики ресурсам вообще и корпусам текстов, удовлетворяющих указанным выше требованиям1.

Наличие категоризации статей и большое количество самих статей в тестируемом источнике данных (Википедия) позволяют получить набор проблемно ориентированных текстов практически на любую тематику2. Таким образом, можно выполнять поиск семантически близких слов как по всей энциклопедии, так и по некоторому подмножеству текстов определённой тематики1.

Разработана архитектура программного модуля RuPOSTagger системы GATE для удалённого доступа к программе морфологического анализа русского языка (использован модуль морфологического анализа русского языка проекта Диалинг). Модуль RuPOSTagger может использоваться как внутри GATE (с другими модулями), так и быть интегрирован в отдельный (standalone) программный продукт. Спроектирована архитектура и реализована система индексирования вики-текстов.

Реализация результатов работы.

Исследования, отражённые в диссертации, были поддержаны грантами РФФИ (проект № 02-01-00284 «Методологические и математические основы построения компьютерных систем быстрой интеграции знаний из распределённых источников» 2002-2004 гг.; № 06-07-89242 "Методология и модели интеллектуального управления конфигурациями распределенных информационных систем с динамически изменяющимися структурами", 2006-2008 гг.; № 05-01-00151 "Методологические и математические основы построения контекстно-управляемых систем интеллектуальной поддержки принятия решений в открытой информационной среде", 2005-2007 гг.), грантами Президиума РАН (проект № 2.44 «Многоагентный подход к построению компьютерной среды для быстрой интеграции знаний из распределённых источников» 2001-2003 гг. и проект № 2.35 «Контекстно-управляемая методология построения распределённых систем интеллектуальной поддержки принятия решений в открытой информационной среде» 2003-2008 гг.), а также грантом ОИТВС РАН (проект № 1.9 «Разработка теоретических основ и многоагентной технологии управления контекстом в распределённой информационной среде» 2003-2005 гг.).

Разработан программный комплекс Synarcher на языке Java для поиска семантически близких слов в энциклопедии Википедия с динамической визуализацией результатов поиска1. Результаты поиска представлены в виде текста (список семантически близких слов), в виде таблицы (с возможностью упорядочения и редактирования) и в виде графического представления набора вершин и рёбер с возможностью показать/спрятать соседние вершины для текущей вершины. Настройка параметров поиска позволяет (i) указать размер пространства поиска, что определяет время поиска и результат, (ii) разрешить поиск статей определённой тематики (то есть сузить область поиска) за счёт выбора категорий статей.

Спроектирована и реализована распределённая клиент-серверная архитектура в программном комплексе Russian POS Tagger2, позволяющая интегрировать среду GATE и модуль морфологической обработки русского языка Lemmatizer (фирма Диалинг). Комплекс RuPOSTagger предоставляет веб-сервис на основе XML-RPC протокола. Веб-сервис обеспечивает вызов функций модуля Lemmatizer из системы GATE или из отдельного Java приложения.

Часть результатов была использована при выполнении контракта «Интеллектуальный доступ к каталогам и документам» на создание системы поддержки клиентов, реализованной для немецкой промышленной компании Фесто, 2003–2004 гг. Разработан и реализован алгоритм кластеризация запросов (на естественном языке) и пользователей на основе использования онтологий в данном проекте [172].

Разработана архитектура программной системы поиска семантически близких слов в исследовательском проекте CRDF № RUM2-1554-ST-05 «Онтолого-управляемая интеграция информации из разнородных источников для принятия решений», 2005-2006 гг.

Апробация результатов работы. Основные положения и результаты диссертационной работы представлялись на международном семинаре «Автономные интеллектуальные системы: агенты и извлечение данных» (Санкт-Петербург 2005), международной конференции «Диалог» (Бекасово 2006), 11ой международной конференции «Речь и Компьютер» (Санкт-Петербург 2006), международной конференции «Корпусная лингвистика» (Санкт-Петербург 2006) и первой конференции в России «Вики-конференции 2007» (Санкт-Петербург 2007). Часть результатов работы представлена в публикациях [33], [36], [35], [57], [58], [168], [169], [170], [171], [172].

Публикации. Основные результаты по материалам диссертационной работы опубликованы в 8 печатных работах, в том числе в 2 журналах из списка ВАК («Труды Института системного анализа РАН», 2004, «Автоматизация в промышленности», 2008).

Структура и объём работы. Диссертационная работа состоит из введения, четырёх глав, заключения, списка литературы и пяти приложений. Работа изложена на 156 страницах и включает 35 рисунков, 14 таблиц, а также список литературы из 190 наименований; приложения на 14 страницах. Общий объём работы составляет 188 страниц.

Основные результаты. Предлагаемые в диссертации алгоритмы позволяют реализовать поиск синонимов и слов близких по значению в наборе текстов специальной структуры.1 В ходе исследований, представленных в диссертации, были получены следующие результаты:

HITS алгоритм адаптирован к поиску наиболее похожих документов (в корпусе текстов с гиперссылками и категориями) на основе алгоритма иерархической кластеризации;

Разработано прикладное программное обеспечение для поиска семантически близких слов в проблемно ориентированном корпусе текстов с динамической визуализацией результатов поиска;

Предложена (1) архитектура распределённой программной системы оценивания результатов поиска на основе тезаурусов (WordNet, Moby) и (2) сами методы численной оценки (адаптация метода Спирмена для сравнения ранжирования в списках разной длины);

Разработана и реализована архитектура подсистемы GATE для удалённого доступа к программе морфологического анализа русского языка (на основе XML-PRC протокола).

Таким образом, в результате исследований, проведённых автором, получено решение актуальной проблемы автоматизированного построения списков семантически близких слов.

В первой главе приводится анализ основных проблем автоматической обработки текста и поиска семантически близких слов. В качестве текстового ресурса выбрана энциклопедия Википедия, рассмотрен ряд алгоритмов и выбран алгоритм HITS1, определён список задач (необходима адаптация алгоритма HITS к корпусу текстов с категориями, необходимо разработать способ оценки работы алгоритма, необходим способ визуализации результатов поиска). Была выбрана система обработки текста на естественном языке – модульная система GATE, позволяющая унифицировать программные компоненты. Указан недостаток системы, который необходимо исправить – это отсутствие доступного модуля в системе GATE для морфологической обработки русского языка.

Во второй главе представлена адаптация алгоритма HITS (с использованием алгоритма кластеризации) к поиску похожих документов2 в корпусе с ссылками и категориями. Приведена оценка временной сложности адаптированного HITS алгоритма. Также предложен алгоритм алгоритм вычисления меры сходства вершин графа. Выполнена оценка временной сложности данного алгоритма и предложены две эвристики, позволяющие уменьшить временную сложность алгоритма. В конце главы предложены методы численной оценки наборов синонимов, полученных на выходе адаптированного HITS алгоритма (это адаптация метода Spearman's footrule и оценка на основе тезаурусов WordNet и Moby).

Третья главе посвящена архитектуре и моделям программ, реализующих разработанные алгоритмы. В главе описана архитектура программы Synarcher, реализующей адаптированный HITS алгоритм, детально описан модуль визуализации программы: интерфейс и функциональность. Описана архитектура программного модуля системы GATE для удалённого доступа к программе морфологического анализа русского языка Lemmatizer (предлагается использовать разработанные автором XML-RPC клиент и сервер). В главе представлена архитектура программной системы, позволяющей оценить построенные списки семантически близких слов. Оценка основана на данных тезаурусов (например WordNet, Moby). Разработана архитектура системы индексирования вики-текстов, включающая программные модули GATE и Lemmatizer. Реализован программный комплекс индексации текстов Википедии на трёх языках: русский, английский, немецкий.

В четвёртой главе описаны эксперименты поиска синонимов в Английской и Русской Википедии с помощью адаптированного HITS алгоритма. Представлен пример работы разработанного автором программного модуля Russian POS Tagger в составе системы GATE. Описаны эксперименты по построению индексных баз данных Русской Википедии и Википедии на английском упрощённом языке.

Подход к поиску семантически близких слов на основе метаинформации в проблемно-ориентированном корпусе, содержащем два типа текстовых документов (статья и категория) и два типа отношений: иерархические отношения (родо-видовые и часть – целое) и гиперссылки.

Адаптированный HITS алгоритм поиска семантически близких слов в корпусе текстовых документов с гиперссылками и категориями. Модификация алгоритма включает: (1) новый способ построения корневого набора (релевантных документов), позволяющий отказаться от предварительного поиска документов, а также (2) использование механизма иерархической кластеризации для объединения слов в смысловые группы.

Клиент-серверная архитектура программного комплекса, предназначенного для решения задачи поиска семантически близких слов с возможностью оценки (с помощью удалённого доступа к тезаурусам и на основе модификации коэффициента Спирмена) семантической близости построенных списков слов.

Программный комплекс поиска семантически близких слов в проблемно-ориентированном корпусе текстов с динамической визуализацией результатов поиска.

Архитектура системы индексирования вики-текстов и её программная реализация.

Для автоматической обработки текста (АОТ) требуются такие ресурсы, как тексты (корпуса текстов), алгоритмы и их реализация в виде программных систем. Данные ресурсы будут рассмотрены в этой главе с точки зрения возможности решения с их помощью поставленных задач.

Данная работа тесно связана с понятиями значение, смысл, семантическая близость слов. По Выготскому Л.С. [16] следует различать «смысл» слова и его «значение». «Смысл, не являясь в отличие от значения, неразрывно связанным с определённой знаковой формой, отличим от знака. Всегда существует возможность выражения одного и того же смысла через различные наборы знаков (курсив наш. – А.К.). Иначе говоря, смысл никогда не связан какой-либо жёсткой знаковой формой. Количество степеней семантической свободы знака обусловлено, в свою очередь, его положением в контексте. <...> Смысл слова неисчерпаем.1 <...> Смысл никогда не является полным.» [16] (цит. по [48]). Таким образом, многовариантность знакового выражения одной и той же вещи (явления) определяет явление синонимии.

«В языке нет полных синонимов. Нет точных соответствий между схожими по значению словами в разных языках» [2]. Это определяется явлениями полисемии (многозначность) [50], омонимии (два или более слова с совершенно разными исконными значениями, одинаковые по форме), синонимии, энантиосемии (одна и та же форма слова может вмещать прямо противоположные значения – просмотрели означает «видели, увидели» и «не увидели» [39].

«Синонимом в полном смысле следует считать такое слово, которое определилось по отношению к своему эквиваленту (к другому слову с тождественным или предельно близким значением) и может быть противопоставлено ему по какой-либо линии: по тонкому оттенку в значении, по выражаемой экспрессии, по эмоциональной окраске, по стилистической принадлежности, по сочетаемости...» [56]. В [56] выделяют две функции синонимов — «уточнительная» (акцентирование того или иного оттенка понятия) и стилистическая.

Однако в работе [18] не делается различия между этими двумя функциями, а утверждается, что важнейшая стилистическая функция синонимов – это наиболее точное выражение мысли. Учитывая смысловые и стилистические отличия синонимов, их разделяют на несколько групп1:

Синонимы, различающиеся оттенками в значениях, называются семантическими (от гр. semantikos – обозначающий), другое название – «идеографические» (гр. idea – понятие, grapho – пишу), или понятийные (молодость – юность, красный – багровый – алый) [18]. Под фразеологическими синонимами понимают “фразеологизмы2 с близким значением, обозначающие одно и то же понятие, как правило, соотносительные с одной и той же частью речи, обладающие частично совпадающей или (реже) одинаковой лексико-фразеологической сочетаемостью, но отличающиеся друг от друга оттенками значения, стилистической окраской, а иногда и тем и другим одновременно” [27].

Синонимы, которые имеют одинаковое значение, но отличаются стилистической окраской, которая не позволяет заменять их в одном контексте, например, глаза – очи – зенки, называются стилистическими [18], [1]. Фразеологические синонимы отличаются большей стилистической однородностью, чем лексические синонимы (состоящие из слов свободного употребления), так как фразеологизмам в основном присуща эмоциональна экспрессивная окрашенность [27].

Синонимы, которые отличаются и по значению, и своей стилистической окраской, называются семантико-стилистическими [18].

Синонимы, представляющие для нейтрального слова его экспрессивные, эмоционально окрашенные дериваты, называются деривационными, например, старик – старикан, старик – старичок [1].

Стоит отметить, что деление синонимов на стилистические и «идеографические» достаточно условное. Поскольку «... материал показывает, что невозможно провести границу между теми и другими, зачислив одни в стилистические, а другие только в идеографические. Основная, подавляющая масса синонимов служит и стилистическим и смысловым (оттеночным, уточнительным) целям, часто выполняя и ту и другую функции одновременно» [56].

Способы определения синонимии в современных системах

В проектах WordNet и EuroWordNet синонимия определяется через понятие взаимозаменяемости. «Два слова (выражения) считаются синонимами, если существует хотя бы один контекст С, в котором замена одного слова другим не приводит к изменению истинностного значения» [99] (цит. по [1]).

Поскольку, во-первых, взаимозаменяемость в контексте не всегда связана с общностью значений, во-вторых, некоторые синонимы не являются взаимозаменяемыми в контексте из-за особенностей синтаксической или же лексической сочетаемости, постольку авторы тезауруса RussNet используют критерий взаимозаменяемости только как дополнительный критерий. Основными критериями семантической близости в RussNet являются идентичность словарных определений или взаимная отсылка в синонимических определениях, что проверяется при дефиниционном анализе [1]. Таким образом, в RussNet отношение синонимии устанавливается между лексико-семантическими вариантами слов, которые (i) принадлежат одной части речи, (ii) имеют сходные значения, (iii) могут быть взаимозаменяемы в контексте.

Следующие типы синонимов определены в тезаурусе РуТез [41]:

Лексические синонимы (полные синонимы; синонимы, отражающие различные языковые стили; синтаксические синонимы; словообразовательные синонимы);

Условные синонимы (сокращения; сложные и сложносокращённые слова; некоторые антонимы1; некоторые родовидовые синонимы2; существительные, обозначающие лиц мужского и женского пола3);

Другие типы (дериваты; образные наименования; фрагменты толкования; энциклопедические синонимы4; исторические синонимы; словосочетания с исключением внутреннего члена; словосочетания с различными реализациями одного из актантов главного слова термина5; термины, тесно связанные отношениям причина-следствие и др.; термины, несущие в себе дополнительную модальность по отношению к основному термину6; термины, совпадающие в одной своей части, а в другой – состоящие из ситуационно связанных терминов7; термины, в которых словосочетание с неоднозначным термином становится однозначным).

Проблема текстовых ресурсов.

К задачам лингвистики относят, с одной стороны, идентификацию структурных единиц (например, морфемы, слова, фразы) и описание того, как одни структурные единицы формируют другие, более крупные (например, по каким правилам можно строить из слов фразы). С другой стороны, благодаря наличию текстов и аудио записей, изучают речь в том виде, как мы её слышим. В этом случае необходимо наличие корпуса – набора текстов с грамматической, синтаксической разметкой или без таковых. Среди множества проблем создания корпуса, можно выделить общую проблему отсутствия единого стандарта и сложности практического характера: опечатки, сохранение переносов в тексте [55]. Данная работа непосредственно связана с корпусной лингвистикой. Проблемы корпусной лингвистики раскрываются в работах [82], [133], [174]. В диссертации в качестве корпуса текстов предлагается использовать коллективную онлайн энциклопедию Википедия. Это позволяет решить в какой-то мере проблему стандарта (все статьи унифицированы, а именно: есть стандартные метаданные – заголовок статьи, категории, определяющие тематику статьи), но появляются новые сложности (например, проблема неравномерности количества и качества статей в зависимости от тематики)1.

Одной из первых работ в области компьютерного семантического анализа можно считать построение «Русского семантического словаря» компьютером в 1982 (группа под руководством чл.-корр. АН СССР Ю. Караулова). Программа сравнивала описание значений слов в разных словарях. При наличии сходства в описании, программа относила слово к одной группе, то есть считала слова сходными по значению. Таким образом, программа является является автоматическим понятийным классификатором слов [48].

В данной работе рассматриваются корпуса проблемно-ориентированных текстов с гиперссылками и категориями. Эти тексты должны отвечать следующим условиям.

Каждому текстовому документу (далее «статья») соответствует одно или несколько ключевых слов, отражающих содержание статьи. Например, в случае энциклопедии – энциклопедической статье соответствует одно слово – название статьи.

Статьи связаны ссылками. Для каждой статьи определены: набор исходящих ссылок (на статьи, которые упоминаются в данной статье) и входящих ссылок (на статьи, которые сами ссылаются на данную статью).

Каждая статья соотнесена одной или нескольким категориям (тематика статьи). Категории образуют дерево таким образом, что для каждой категории есть родитель-категория (кроме корня) и один или несколько детей-категорий (кроме листьев).

Данная структура является не абстрактным измышлением. Она имеет конкретное воплощение в структурах типа вики (wiki), получивших широкое распространение в последнее время в сети Интернет, например, в виде электронной онлайн энциклопедии Википедии1; “вики используется российскими органами власти2 и Департаментом образования Москвы3 при создании административных интернет-сайтов.”4

Наличие единообразных метаданных (заголовок документа, категории), принадлежащих документам корпуса, позволяет отнести поисковую систему, выполняющую поиск на основе этих данных, к классу гипертекстовых информационно-поисковых систем5. Разработке такой системе посвящена данная работа.

Алгоритмы, выполняющие поиск похожих документов и близких по значению слов, можно условно1 разделить на группы:2

поиск на основе анализа ссылок (вычисления на графах)

ссылки заданы явно гиперссылками (HITS [125], PageRank [85], [102], ArcRank [174], Green [145], WLVM [134]);

ссылки нужно построить3 (Similarity Flooding [132], алгоритм извлечения синонимов из толкового словаря [84], [83], [174]);

поиск на основе анализа текста:

статистические алгоритмы (ESA [103], сходство коротких текстов [159], извлечение контекстно связанных слов на основе частотности словосочетаний [146]);

автоматическое понимание текстов4;

поиск на основе анализа и ссылок и текста [81], [129]5.

Для уточнения результатов поиска могут использоваться данные о семантически близких словах из тезаурусов Роже, WordNet, Moby, Викисловаря и др.

Входными данными могут быть [106]:

запрос, состоящий из ключевых слов, тогда будет выполняться поиск документов, похожих на запрос;

идентификатор документа, будут искаться документы, похожие на заданный.6

Алгоритм HITS (Hyperlink-Induced Topic Selection)3 позволяет находить Интернет страницы, соответствующие запросу пользователя, на основе информации, заложенной в гиперссылки [125]. Демократическая природа Интернет позволяет использовать структуру ссылок как указатель значимости страниц (эта идея есть и в алгоритме PageRank [85], встроенном в поисковик Google). Страница p, ссылаясь на страницу q, полагает q авторитетной, стоящей ссылки. Для поиска существенно, что страница q соответствует тематике страницы p.

Поиск в Интернет (Web search) – это нахождение релевантных страниц, соответствующих запросу. Можно выделить два крайних типа запросов: конкретный (проблема недостатка страниц) и чрезмерно общий (проблема избытка страниц). При наличии общего запроса ставится задача дистилляции широких поисковых тем с помощью авторитетных источников по этим темам.

HITS алгоритм использует такие понятия, как: авторитетный документ и хаб-документа (или авторитетная и хаб-страница). Авторитетный документ – это документ, соответствующий запросу пользователя, имеющий больший удельный вес среди документов данной тематики, то есть большее число документов ссылаются на данный документ. Хаб-документ – это документ, содержащий много ссылок на авторитетные документы.4

Параметр PageRank страницы p(i) (её авторитетность) определяется так [102]:

|

|

(1.1) |

где N – общее число страниц; j→i обозначает гиперссылку от страницы j к странице i; Kout(j) – это число исходящих ссылок страницы j; (1-q) – амортизирующий коэффициент (damping factor)1. Набор уравнений (1.1) решается итеративно.

Оба алгоритма: PageRank и HITS предлагают общую идею итеративного вычисления авторитетных страниц, где авторитетность определяется наличием (количеством) и характером (степень авторитетности источника) ссылок. Однако есть и разница. Отличие алгоритма PageRank от алгоритма HITS в том, что у каждой страницы только один параметр, который соответствует её популярности, это вес PageRank. В алгоритме HITS каждой странице сопоставлено два параметра, которые определяют авторитетность и наличие ссылок на авторитетные страницы. Это соответственно параметры authority и hub. Отметим, что PageRank не требует дополнительных вычислительных затрат во время обработки запроса, HITS более дорогой с вычислительной точки зрения алгоритм.

В работе [89] указывают на сходство результатов работы HITS и PageRank2. Большинство документов, полученных как авторитетные в HITS, были представлены в результатах PageRank, но упорядочены были по другому. Однако в другой работе [80] при поиске авторитетных страниц с помощью алгоритмов HITS и PageRank по всей Английской Википедии и по некоторым подмножествам страниц (например: People, Historical Events, Countries and Cities)1 были получены в общем разные классы концептов. Также в работе [145] приводятся эксперименты по сравнению различных методов поиска похожих статей в ВП, в том числе сравнивают работу алгоритмов LocalPageRank2 и PageRankOfLinks (аналог PageRank) в пользу последнего. Авторы [145] делают вывод, метод HITS ищет хуже похожие статьи в ВП, чем PageRank, поскольку считают метод LocalPageRank аналогичным методу HITS. Скорее всего, это не верный вывод, поскольку LocalPageRank и HITS – разные алгоритмы – они используют разное число весов для каждой страницы. Таким образом, требуются дополнительные исследования по сравнению алгоритмов с помощью экспериментов.

О популярности алгоритма PageRank говорит наличие нескольких его модификаций. В работе [145] предложены методы Green, SymGreen для поиска «вершин, семантически связанных с исходной». Эти методы являются модификациями алгоритма PageRank на основе Марковских цепей.

Алгоритм предназначен для поиска семантически близких слов, а не синонимов. ArcRank вычисляет рейтинг вершин аналогично алгоритму PageRank. Небольшая модификация в том, что вершинам источникам3 и висячим вершинам4 не присваиваются предельные значения.

В ArcRank дугам назначаются веса на основе весов вершин. Если |as|

– число исходящих дуг из вершины s, pt

– вес вершины t, тогда важность (relevance) дуги (s,t)

определяется так [174]:

При выборе слов, связанных с w, первыми выбираются те рёбра, инцидентные w, которые имеют больший вес.

Алгоритм векторной модели ссылок Википедии (англ. Wikipedia Link Vector Model или WLVM) вычисляет сходство двух статей ВП на основе содержащихся в них ссылок [134]. Алгоритм включает шаги:

по заданному термину получить все статьи ВП с похожими заголовками;

обработать ссылки (разрешить «редиректы»1; для ссылок на страницы «дизамбиги»2 взять все ссылки, перечисленные на «дизамбигах»);

подсчитать вес ссылок (см. ниже);

построить вектор (исходящих) ссылок для каждой страницы;

из множества пар статей (для двух терминов) выбираются наиболее похожие, то есть с наименьшим углом между векторами ссылок.

Семантическое сходство двух страниц ВП определяется углом между векторами ссылок этих страниц. Сходство будет выше, если обе страницы ссылаются на страницу, на которую мало ссылаются другие страницы.

Вес ссылки с исходного документа на целевой определяется по правилам:

1 или 0, если есть или нет такая ссылка в исходном документе;

обратно пропорционально общему числу ссылок на целевой документ.

А именно, вес ссылки w со страницы a

на страницу b рассчитывается по формуле:

,

где t — общее число страниц в ВП.

,

где t — общее число страниц в ВП.

Для оценки алгоритма использовался тестовый набор 353-TC.3 Была предпринята малоуспешная попытка автоматически выбирать верное значение для ссылок на многозначные статьи: коэффициент корреляции Спирмена с эталонным набором оказался равным 0.45, при разрешении многозначных статей вручную — 0.72. Доступна реализация WLVM алгоритма.1

Одна из задач, рассматриваемых в диссертации2, относится к типу задач scheme / ontology alignment (другое название – scheme / ontology matching). Суть этой более общей задачи в том, что «на входе есть две схемы / онтологии, каждая из которых состоит из дискретных сущностей (например, таблицы, XML элементы, классы, свойства, правила, предикаты), на выходе должны быть получены отношения (например отношение эквивалентности, отнесение к некоторой категории), связывающие эти сущности» [164].

Этот тип задач замечателен тем, что включает и лексическую3, и семантическую4 компоненты. Обзор современных работ по scheme / ontology matching представлен в [164], критический обзор открытых (open source) программных систем изложен в [190].

Кратко опишем несколько работ, посвящённых данной теме. Затем более подробно осветим алгоритм Similarity Flooding и алгоритм извлечения синонимов из толкового словаря.

Итак, в работе [77] для обнаружения неявных (latent) связей между вершинами считают число общих соседей двух вершин. Сходство двух вершин (relevance measure) вычисляется как отношение числа общих вершин к числу всех соседних вершин ([77], стр. 3). Авторы поставили себе общую задачу – обнаружение отношений в семантическом графе5. Эксперименты заключались в предсказании возможных атак и уязвимостей служб безопасности на основе видеофильмов и данных терактов.

Поиск похожих вершин в графах возможен с помощью поиска соответствий между вершинами (отображений). Во-первых, точное соответствие, одна вершина к одной (рассматривается в данной работе, стр. 86). Во-вторых, неточное – многие к одной или многие к многим, то есть кластер концептов отображается в один концепт. В работе [97] предложен алгоритм неточного сравнения графов онтологий1 на основе максимизации ожидания2. Онтология представлена в виде направленного графа с метками.

Кратко опишем один из алгоритмов, решающих описанную выше задачу scheme / ontology alignment, – алгоритм Similarity Flooding, ключевая идея которого в том, что «два элемента считаются сходными, если сходны их соседи. Сходство двух элементов распространяется на их соседей» [132]. На первом шаге в соответствии с входными схемами, которые нужно сравнить (например SQL таблицы или запросы), строятся два графа. На втором шаге задаются начальные значения сходства между вершинами двух графов, путём сравнивая имён вершин. На третьем шаге итеративно вычисляется сходство вершин до тех пор, пока суммарное изменение степени сходства по всём вершинам больше наперёд заданного ε. Значение сходства между вершинами учитывается для вычисления сходства соседних вершин. На четвёртом шаге выбираются наиболее похожие пары вершин.

Таким образом, алгоритм Similarity Flooding находит похожие вершины, принадлежащие разным графам, то есть вычисляет меру сходства вершин графа. Разработанный и рассматриваемый в диссертации алгоритм (стр. 86) предназначен для поиска вершин, похожих на заданную, в одном и том же графе. В этом отличие разработанного алгоритма от алгоритма Similarity Flooding.

В работах [84], [83], [174] французские учёные, под руководством Винсента Блондела (Vincent Blondel), предлагают обобщение HITS алгоритма для поиска синонимов в толковом словаре.1

Предположим, что (1) синонимы имеют много общих слов в определениях (в статьях толкового словаря); (2) синонимы часто употребляются в определении одних и тех же вокабул2. Построим граф G, в котором вершины соответствуют вокабулам словаря. Строится дуга от вершины u к v, если слово, соответствующее v, встречается в определении вокабулы u.

Пусть ищем синонимы для слова w. Для этого строим Gw (подграф графа G), включающий (1) все вершины из G, ссылающиеся на w и (2) все вершины, на которые ссылается w. Считаем сходство слов относительно слова w, чтобы выбрать лучшие слова как синонимы.

Сходство между

вершинами графа вычисляется так. Каждой вершине i графа Gw

назначаем три веса

![]() ,

,

![]() ,

,

![]() с начальным значением единица. Веса обновляются итеративно по такому

правилу:

с начальным значением единица. Веса обновляются итеративно по такому

правилу:

Вес

![]() равен сумме весов

равен сумме весов

![]() всех вершин j, на которые указывает вершина i;

всех вершин j, на которые указывает вершина i;

Значение

![]() равно сумме весов

равно сумме весов

![]() (вершин, на которые указывает вершина i) и

(вершин, на которые указывает вершина i) и

![]() (вершин, указывающих на i).

(вершин, указывающих на i).

Значение

![]() равно сумме весов

равно сумме весов

![]() вершин, указывающих на i.

вершин, указывающих на i.

На каждом шаге веса одновременно обновляются и

нормализуются. Синонимами считаются слова с максимальным значением

![]() (центральный вес). Вычисления проводились на английском словаре

Вебстера. Построенный граф содержал 112 169 вершин, 1 398 424 рёбер.

(центральный вес). Вычисления проводились на английском словаре

Вебстера. Построенный граф содержал 112 169 вершин, 1 398 424 рёбер.

В работе [103] авторы описали алгоритм ESA, позволяющий представить значение любого текста в терминах концептов ВП.1 Оценка эффективности метода выполнена за счёт автоматического вычисления степени семантической связи между фрагментами текста произвольной длины на ЕЯ.

Для ускорения работы построили инвертированный индекс: слову соответствует список концептов, в статьях которых оно появляется. Была выполнена предобработка концептов ВП:

удалили концепты, которым соответствуют небольшие статьи (меньше 100 слов, меньше 5 исходящих и входящих ссылок);

удалили стоп-слова и редкие слова;

получили леммы слов (тексты на английском языке).

В алгоритме ESA на вход подаются два текста. По ним строятся два вектора из концептов ВП следующим образом. По фрагменту текста (1) строится вектор по TF-IDF схеме, (2) из инвертированного индекса выбираются концепты и объединяются во взвешенный вектор2. Произведение этих векторов и даёт вектор концептов ВП релевантных фрагменту текста. Для сравнения текстов сравнивают два вектора, например, с помощью косинусного коэффициента.

Эксперименты в работе [103] показали преимущество ESA в точности поиска семантически близких слов в ВП по сравнению с алгоритмами поиска LSA [100], WikiRelate! [173] и других, выполняющими поиск на основе данных WordNet, Роже и ВП. Достоинство метода также в том, что он позволяет определять значение многозначного слова.

Метод извлечения контекстно связанных слов на основе частотности словосочетаний предлагается в [146] для поиска контекстно похожих слов (КПС) и для машинного перевода. Данными для поиска КПС служат (1) семантически близкие слова из тезауруса, (2) словосочетания из базы данных (БД) с указанием типа связи между словами. Для слова w формируется cohort w, то есть группа слов, связанных одинаковыми отношениями со словом w, из базы словосочетаний. КПС слова w – это пересечение множества похожих слов (из тезауруса) с cohort w. Работа [146] интересна формулами, предлагаемыми для вычисления сходства между группами слов.

Обычно вычисляется сходство между отдельными парами слов. В работе [146] вычисляется сходство между группами слов G1 и G2 на основе формул, предложенных в [122]. Вершины графа – слова, взвешенные рёбра указывают степень сходства между словами (таким образом, матрица инциденций – sim – матрица сходства, хранит сходство между отдельными элементами). Вычисляются:

AI –

absolute

interconnectivity

(абсолютная связность), как суммарная сходство между всеми парами в

группах:

![]() .

.

AC

– absolute

closeness

(абсолютная близость или плотность) определяется как среднее сходство

между парами элементов:

Разница между AI и AC в том, что в AC учитывается пары имеющие нулевое сходство (рис. 1).

В [122] предлагает нормализовать абсолютную связность и близость за счёт вычисления внутренней связности и близости отдельных групп. Внутренняя связность и близость определяются на основе вычисления разбиения каждой группы (поиск за O(N) минимального числа рёбер, удаление которых приведёт к разбиению графа на две части).

Рис. 1. Пример, иллюстрирующий разницу между мерами AI и AC. Значение AI в случаях (a) и (b) остаётся постоянным, но значение AC в случае (a) больше, поскольку в (b) больше вершин, не имеющих похожих вершин [146]

Можно упомянуть ещё ряд статистических алгоритмов для вычисления семантической близости слов: LSA [100], PMI-IR [180].

Выделяют несколько способов

определения похожих документов1

[53].

Полагаем, что документы и запросы представляются с помощью индексных

терминов или ключевых слов.

Обозначим посредством символа |.| – размер множества ключевых

слов, представляющих рассматриваемый документ. Простой

коэффициент соответствия

![]() показывает количество общих

индексных терминов. При вычислении коэффициента не берутся в

рассмотрение размеры множеств X

и Y.

показывает количество общих

индексных терминов. При вычислении коэффициента не берутся в

рассмотрение размеры множеств X

и Y.

Таблица 1.1

Коэффициенты сходства для документов, для ключевых слов [53]

|

Формула |

Название |

|---|---|

|

|

Коэффициент Дайса (dice) |

|

|

Коэффициент Джаккарда (jaccard) |

|

|

Косинусный коэффициент |

|

|

Коэффициент перекрытия |

В таблице 1.2 показаны способы вычисления степени сходства, основанные на учёте:

частотности слов в корпусе;

расстояния в таксономии;

одновременно и частотности слов, и расстояния в таксономии.

Таблица 1.2

Классификация метрик и алгоритмов вычисления степени сходства слов

|

Формула / ссылка на описание алгоритма |

Название |

|---|---|

|

1. Учёт частотности слов в корпусе |

|

|

|

Нормализованное расстояние Google (NGD)1 |

|

|

jaccard2 [173] |

|

Описание алгоритма см. на стр. 34. |

ESA [103] |

|

2. Учёт расстояния в таксономии3 |

|

|

Расстояние соответствует числу ребер кратчайшего пути между концептами |

Метрика применялась для концептов Тезауруса Роже [117] |

|

|

Leacock & Chodorov 1997, [99] стр. 265-283 |

|

|

Wu & Palmer [186] |

|

|

Метрика res [151], адаптированная к таксономии категорий ВП [173]

|

|

3. Учёт частотности слов и расстояния в таксономии |

|

|

|

Расстояние res [151], [152] |

|

|

Расстояние lin1 [128] |

|

4. Учёт пересечения текста |

|

|

пересечение текста (глоссы WordNet) |

Lesk, 1986 [74] |

|

extended gloss overlap – пересечение глосс с учётом глосс соседних концептов WordNet |

Banerjee & Pedersen, 2003 [75] |

|

|

[173] |

Расстояние Google – это мера семантической связности, вычисленная на основе числа страниц, полученных с помощью поисковика Google для заданного набора ключевых слов. В таблице приведена формула вычисления нормализованного расстояния Google (NGD) для двух слов: x и y, где М – это общее число веб-страниц, проиндексированных Google; f(x) и f(y) – число страниц, содержащих ключевые слова x и y, соответственно; f(x, y) – число страниц, содержащих сразу и x, и y. Если x и y на всех страницах встречаются вместе, то полагают NGD=0, если только по отдельности, то NGD=∞.

Выделим класс метрик, вычисляющих сходство на основе данных таксономии (табл. 1.2). Данные метрики используются для вычисления сходства концептов WordNet [74], [99], [128], [151], [152], [186], GermaNet [139], ВП [173].

В книге [99]

Leacock и Chodorov предложили

вычислять близость концептов как расстояние между концептами в

таксономии, нормализованное за счёт учёта глубины таксономии. В

формуле

,

функция length(c1, c2)

– это число вершин вдоль кратчайшего пути между вершинами c1

и c2;

D – максимальная

глубина таксономии. В работе [99]

авторы рассмотрели

только одно отношение is-a

и только между существительными.

,

функция length(c1, c2)

– это число вершин вдоль кратчайшего пути между вершинами c1

и c2;

D – максимальная

глубина таксономии. В работе [99]

авторы рассмотрели

только одно отношение is-a

и только между существительными.

В работе [186]

предложена формула, учитывающая как глубину концептов в иерархии, так

и глубину ближайшего общего родителя lcs

(least common subsumer):

.

.

Резник [151]

предложил считать, что два слова тем более похожи, чем более

информативен концепт, к которому соотнесены оба слова, то есть чем

ниже в таксономии находится

общий верхний концепт (синсет в WordNet).1

При построении вероятностной функции P(C),

потребуем, чтобы вероятность

концепта не уменьшалась при

движении вверх по иерархии:

![]() .

Тогда более абстрактные концепты будут менее информативны. Резник

предложил оценивать вероятность через частоту

синонимов концепта в корпусе таким образом:

.

Тогда более абстрактные концепты будут менее информативны. Резник

предложил оценивать вероятность через частоту

синонимов концепта в корпусе таким образом:

,

,![]() ,

где words(C) –

это существительные2,

имеющие значение C;

при этом N –

общее число существительных в корпусе. Пусть, если для двух концептов

ближайшим общим концептом является корневая категория, то сходство

равно нулю.

,

где words(C) –

это существительные2,

имеющие значение C;

при этом N –

общее число существительных в корпусе. Пусть, если для двух концептов

ближайшим общим концептом является корневая категория, то сходство

равно нулю.

В работе [173] метрика Резника res была адаптирована к ВП и информативность категории P(C) вычислялась как функция от числа гипонимов (категорий в ВП), а не статистически3 (то есть не посчитали частотность термов в ВП):

,

,

где lcs — ближайший общий родитель концептов с1 и с2, hypo — число гипонимов4 этого родителя, а С — общее число концептов в иерархии.

Lin [128]

определил сходство объектов А

и B как отношение

количества информации, необходимой для описания сходства А

и B, к количеству

информации, полностью описывающей А

и B. Для измерения

сходства между словами Lin учитывает частотное распределение слов в

корпусе текстов (аналогично

мере Резника):

,

где c0

– ближайший общий супер-класс в иерархии для обоих концептов c1

и c2.

P – вероятность

концепта, вычисляемая на основе частоты появления концепта в корпусе.

Отличается от формулы res

способом нормализации, корректным вычислением

lin (x, x) (не зависит

от положения концепта х

в иерархии), учитывает наличие и общих, и различающихся свойств у

объектов [152].

,

где c0

– ближайший общий супер-класс в иерархии для обоих концептов c1

и c2.

P – вероятность

концепта, вычисляемая на основе частоты появления концепта в корпусе.

Отличается от формулы res

способом нормализации, корректным вычислением

lin (x, x) (не зависит

от положения концепта х

в иерархии), учитывает наличие и общих, и различающихся свойств у

объектов [152].

В работе [173] мера lesk, основанная на вычислении степени пересечения глосс концептов WordNet, была адаптирована к ВП (за глоссу авторы взяли первый абзац в статье ВП). Итак, сходство двух текстов t1, t2 вычисляется с двойной нормализацией (по длине текста и с помощью гиперболического тангенса) так:

,

,

![]() ,

где пересекаются n фраз, m слов1.

,

где пересекаются n фраз, m слов1.

В работе [139] (стр. 4) приведённая в таблице 1.2 формула lin была адаптирована к поиску в структуре GermaNet. В данной работе приведены две TF-IDF схемы для вычисления сходства между запросом и текстом документа.

Глава о метриках была бы неполной без упоминания того, что кроме сходства, метрики позволяют вычислять степень различия объектов. Так например, в задачах кластеризации используются функции, определяющие степень различия2 между документами. Если P – множество объектов, предназначенных для кластеризации, то функция D определения степени различия документов удовлетворяет следующим условиям [53]:

![]() для

для

![]()

![]() для

для

![]()

![]() для

для

![]()

![]() для

для

![]()

При анализе свойств Интернет сетей1, при оценке свойств графов, созданных с помощью генератора случайных чисел, используют такие метрики [130]:

Распределение расстояний d(x) – число пар вершин на расстоянии х, делённое на общее число пар n2 (включая пары типа (a,a));

betweeness – мера центральности – взвешенная сумма числа кратчайших путей, включающих данную вершину (ребро);

вероятностное распределение вершин P(k) – число вершин степени k в графе;

правдоподобие (likelihood) – сумма произведений степеней смежных вершин;

кластеризация2

С(k) –

отношение среднего числа ссылок между соседями вершины степени k

к максимально возможному числу таких ссылок ![]() .

.

Автоматическая обработка текстов (АОТ) на естественном языке (ЕЯ) подразумевает наличие как программных систем1, обрабатывающих тексты, так и корпусов, содержащих эти тексты. Общие проблемы создания программных систем рассматриваются в работе [12].

В данной работе под корпусом текстов понимают «набор текстов доступных для машинной обработки, на основе которых можно проводить какие-либо лингвистические исследования» [133].

Проблема отсутствия общепринятых стандартов для корпусов текстов приводит к тому, что для каждого отдельного корпуса создаётся своя система АОТ. Одно из решений этой проблемы, реализованное в виде системы GATE, предлагают английские учёные из университета Шеффилд.

Система GATE (General Architecture for Text Engineering) предлагает инфраструктуру для разработки и внедрения программных компонент с целью обработки текста на ЕЯ. Эта система (i) определяет архитектуру, то есть способ организации данных и программных компонент, обрабатывающих текст, (ii) предлагает реализацию архитектуры (набор классов, который может встраиваться в программные приложения независимо от GATE), (iii) помогает разрабатывать и использовать компоненты с помощью графического инструментария [92].

Система GATE написана на языке Java [8], [25], [68], [115], имеет модульную структуру, предоставляется на правах лицензии GNU library licence2. С научной точки зрения достоинство GATE заключается в возможности проводить численные измерения текста, которые можно повторить. В работе [109] критикуют систему GATE за плохую масштабируемость и за то, что она плохо справляется с большими коллекциями документов. Однако отмечают «большой потенциал GATE как инструмента для планирования и разработки приложений АОТ в области Information Extraction».

Модульность архитектуры позволяет (i) включать только необходимые компоненты, (ii) использовать имеющиеся наработки, (iii) начать работу с уже существующими компонентами, по мере необходимости, создавая новые.

В системе GATE можно выделить компоненты, не зависящие от языка текста (например Doc Reset) и зависящие (например, English POS Tagger). Система GATE позволяет обрабатывать документы на таких языках, как: английский, французский, немецкий, арабский, китайский и др. Это определяется наличием соответствующего модуля.

В системе GATE предложен следующий способ автоматической аннотации текстовых документов.1 GATE позволяет связать подстроку текста документа (слово, фраза, предложение) с аннотацией. Аннотации описывают иерархическое разбиение текста, простой пример – это разбиение текста на слова (tokens). Более сложный пример (при полном синтаксическом анализе) – это декомпозиция предложения на именную, глагольную группы слов с выделением главного слова и т. п.

Отсутствуют (по крайней мере, неизвестны автору) доступные модули в системе GATE для морфологической обработки русского языка. Возможно, поэтому система GATE редко упоминается в системах обработки текстов на русском языке. Отрадное исключение представляют работы [64], [98], где представлены архитектура и реализация системы OntosMiner.

Для оценки качества функционирования систем Information Extraction (IE) используются такие метрики, как: точность (Precision), полнота (Recall) и качество (F-measure)2. В работе [64] предлагается новая система метрик, в которой «аннотация представляется в формате, где явно специфицированы тип выделенного объекта (отношения) и его атрибуты, а также расположение аннотации в тексте относительно его начала (Offsets)». С одной стороны, указание типа объекта и положения подстроки в тексте (Offsets) сужает понятие объекта (именно объектами оперируют метрики точность, полнота и качество). С другой стороны, новые метрики подходят для оценки качества функционирования IE систем, построенных на основе GATE, поскольку тип объекта и положения подстроки в тексте включены в аннотации GATE.

Небольшой обзор систем, подобных GATE, а именно: KIM, TEXTRACT, Textpresso, Ogmios, представлен в работе [109].

В данном подразделе дано краткое описание модулей автоматической обработки текста и морфологических словарей, разработанных рабочей группой Aot.ru [60]. Изначальный проект, посвящённый разработке русско-английского машинного перевода, назывался Диалинг. Разработанный процессор Диалинг включает графематический, морфологический и синтаксическим модули. Программная реализация процессора выполнена на языке C++. «Неоспоримым достоинством процессора Диалинг является его завершённость: программная реализация доведена до уровня промышленного использования, – система характеризуется приемлемой скоростью анализа и устойчивостью на открытом пространстве реальных текстов» (цит. по [47]).

Морфологический словарь, или лексикон, содержит все словоформы одного из языков: английский, немецкий или русский. Словарь предоставляется в двух вариантах: с возможностью редактирования и в бинарном варианте. Оболочка редактирования словаря позволяет выполнять: (i) поиск в словаре по лемме, словоформе, морфологической интерпретации, (ii) редактирование словаря. Словарь в бинарном формате предоставляет возможность выполнять: (1) морфологический анализ (получение по словоформе леммы, её свойств, уникального ID леммы, морфологических характеристик входной словоформы1 и (2) морфологический синтез (получение по уникальному ID леммы всей парадигмы слова со всеми словоформами и их морфологическими характеристиками). Бинарное представление словаря оптимизировано для проведения морфологического анализа. Основу этого представления составляет конечный автомат. Работает морфологическое предсказание слов, отсутствующих в словаре [60].

В прикладной части данной диссертационной работы для нормализации слов используется программа морфологического анализа (Lemmatizer)1. Например, для текста «смерч обрушился на южные селенья» нормализованным вариантом будет – «смерч обрушиться на южный селение» [31].

Тезаурус – это сложный компонент словарного типа, отражающий основные соотношения понятий в описываемой области знаний [41]. Тезаурусы включают всю терминологию, специфическую для предметной области (ПО), а также парадигматические отношения2 между понятиями ПО. Тезаурус может выполнять разные функции в разных системах [41]:

является источником специальных знаний в узкой или широкой ПО, способом описания и упорядочения терминологии ПО;

является инструментом поиска в ИПС [17];

является инструментом ручного индексирования документов в ИПС (так называемый контролирующий словарь);

является инструментом автоматического индексирования текстов.

Одним из наиболее успешных проектов, связанных с тезаурусами, является WordNet3 [99] – тезаурус английского языка, представляющий состав и структуру лексического языка в целом, а не отдельных тематических областей [1]. WordNet группирует наборы слов со схожим значением в синсеты1 (от англ. synonym set, synset). WordNet содержит синсеты, краткие общие определения к синсетам (глоссы), примеры употреблений и несколько типов семантических отношений между синсетами. Авторы преследовали двоякую цель: объединить возможности тезауруса и наглядность словаря, а также создать ресурс для автоматической обработки текстов на естественном языке. База данных и программа выпущены на условиях BSD лицензии. Возможен онлайн доступ к содержимому базы данных.

WordNet был разработан в 1985 г. Работа над ним ведётся сотрудниками Лаборатории когнитологии Принстонского Университета (США) под руководством профессора психологии Дж. Миллера. К 2005 г. WordNet содержал около 150 тыс. слов, организованных в более чем 115 тыс. синсетов, всего 203 тыс. пар слово-значение. Словарь состоит из 4 файлов, соответствующих таким частям речи, как: существительное, глагол, прилагательное и наречие.

Семантические отношения связывают большинство синсетов. Представлены такие семантические отношения, как: гипонимия (родовидовое), меронимия (часть-целое), лексический вывод (каузация, пре-суппозиция) и др.

Гипонимия позволяет организовывать синсеты в иерархические структуры (деревья). Гипонимия связывает слова, «между содержанием понятий которых существует отношение семантического включения, то есть значение гиперонима полностью включено в значение гипонима» [1]. Например, значение слова бояться включено в значение слов опасаться, остерегаться.

Разработаны способы вычисления семантического расстояния между концептами либо словами с помощью тезауруса WordNet, например: мера Leacock-Chodorow [99],2 меры на основе частотности концептов в корпусе (мера Резника [151], [152], мера Jiang-Conrath [120], мера Lin [128]), мера Hirst-St.Onge, мера пересечения расширенных глосс1. В работе [87] проведены эксперименты по сравнению пяти мер, вычисляющих семантическое расстояние между терминами WordNet. Эксперименты показали, что лучшие результаты даёт мера JiangConrath. Также обзор нескольких мер и эксперименты с ними представлены в диссертации итальянского учёного Calderan M. [90].

Данные WordNet используются для решения таких задач, как определение значения слова (WSD2) [138]3, [153], [187], вычисление логичности и связности предложений в тексте [110], [175], построение баз знаний [17] и тезаурусов.

В работе [154] авторы задались целью показать, что комбинация эвристик позволяет построить полную таксономию современного словаря на любом языке. В результаты были разработаны: (1) метрика расстояния между двумя словами (в двуязычном словаре) на основе таксономии гипонимов / гипернимов WordNet, (2) эвристики (и методика их интеграции) для определения значения (WSD) родовых терминов4 двух словарей, (3) построена таксономия для испанского и французского языков на основе машинных словарей DGILE (испанский) и LPPL (французский).

Работа [121] интересна критикой WordNet. Авторы предложили итеративный способ решения задачи WSD на основе корпуса и словаря. Слова считаются похожими, если встречаются в похожих предложениях. Предложения похожи, если содержат похожие слова. Авторы разработали меры сходства сходства слов и предложений, обладающие особенностями: ассиметричность, транзитивность, сходимость. Благодаря транзитивности данный метод позволяет оценивать сходство редких фраз, отсутствующих в корпусе. Были использованы данные словарей Webster, Oxford и WordNet. В экспериментах WordNet показал слабые результаты. Возможные причины таковы [121]:

архитектура WordNet не предназначена для хранения данных о контекстном сходстве;

расстояние в дереве WordNet (длина пути между концептами) не всегда соответствует интуитивным представлениям сходства слов, так как разные концепты находятся на разном уровне абстракции, имеют разное число гиперонимов.

Система WordNet используется во многих современных проектах, что, в свою очередь, приводит к появлению научно-исследовательских проектов, направленных на улучшение самой базы WordNet. В работе испанских учёных [158] предлагается использовать данные энциклопедии Википедия для расширения сети концептов WordNet. Авторы предлагают способ автоматического установления соответствия между статьями энциклопедии и концептами онтологии (здесь – семантической сети WordNet).1 Для решения задачи авторы строят упрощённую версию Английской Википедии2 таким способом, что из всех статей оригинальной Википедии были выбраны только те, заголовкам которых был найден соответствующий концепт в WordNet.3 Для вычисления метрики сходства между статьёй Википедии и концептом WordNet использовалась модель VSM (Vector Space Model).

Далее будут описаны отечественные лингвистические базы данных и тезаурусы: каталог семантических переходов, тезаурус РуТез, Русский Викисловарь, а также тезаурус GEMET.

«Каталог семантических переходов» – база данных регулярно воспроизводимых лексико-семантических изменений, засвидетельствованных в различных языках мира [21]. В этой БД выделено шесть типов семантических переходов (смысловых связей между словами), интересных с точки зрения изучения этимологии слов и создания этимологических словарей:

полисемия;

семантическая эволюция – изменение значения слова на разных временных срезах одного и того же языка;

когнаты – «лексемы с двумя значениями, находящимися в отношении семантической производности, в родственных языках восходят к одной лексеме праязыка, в которой предположительно отсутствует соответствующая полисемия» [21];

заимствование – семантическая адаптация иноязычных слов, в ходе которой может измениться значение слова;

морфологическая деривация – образование новых значений при добавлении аффиксов (например «любить» – «любой»);

грамматикализация – процесс превращения лексических единиц с ходом эволюции языка в грамматические показатели (например, глагол «стать» в конструкции «стану работать» означает начало действия в будущем времени).

Особенностью другой системы – тезауруса РуТез [41] является автоматическое индексирование. Термины тезауруса делятся на дескрипторы и варианты (синонимы) дескрипторов. Дескрипторы представлены отдельными существительными и именными группами. Синонимами могут быть две упомянутые грамматические группы, а также отдельные прилагательные, глаголы и глагольные группы. Применяются следующие правила включения дескрипторов в тезаурус:

Наличие связи с другими дескрипторами;

Наличие (если это словосочетание) таких тезаурусных связей, которые не вытекают из структуры словосочетания. Например, словосочетание аренда земли является свободным словосочетанием, и сумма значений его составляющих равна значению всего словосочетания, при этом, аренда земли является одним из видов землепользования, и эта неочевидная связь служит основанием для включения этого словосочетания в тезаурус.

В РуТез включаются термины, не упоминавшиеся в текстах, если они: (а) нужны для объединения разрозненных дескрипторов, (б) пополняют ряд нижестоящих дескрипторов для уже существующего дескриптора. Предусмотрено включение многозначных терминов, а именно: несколько значений одного термина представляются разными дескрипторами. Если только одно значение многозначного термина включено в тезаурус, то дескриптор снабжается пометой «М». В тезаурус включены фразеологизмы, в состав которых входят термины тезауруса: например, как с гуся вода, водой не разольёшь и др. Отношения в тезаурусе (ВЫШЕ-НИЖЕ1, ЦЕЛОЕ-ЧАСТЬ2, АССОЦИАЦИЯ) позволяют представить тезаурус в виде связной иерархической сети (разрешена только одна компонента связности).

Достоин упоминания тезаурус GEMET3. Интересными особенностями тезауруса является привязка концептов ко многим языкам (в том числе к русскому), предоставление данных с помощью веб-сервиса (RDF). Авторы GEMET планируют улучшить данные тезауруса за счёт включения его в Английский Викисловарь4 и отдачи со стороны пользователей Викисловаря.

Викисловарь является с одной стороны вики-ресурсом, поэтому в его пополнении может участвовать каждый, с другой – это толковый, грамматический, фразеологический, этимологический и многоязычный словарь, в том числе и тезаурус.5 Русский Викисловарь содержит следующие семантические отношения: синонимы1, антонимы2, гиперонимы, гипонимы, согипонимы, холонимы, меронимы, паронимы3, омонимы4.

Разработка словарей требует огромных вложений времени и сил. Поэтому тезаурусы WordNet, Роже покрывают небольшую часть лексикона, и содержат мало имён собственных, неологизмов, жаргонных слов, специальной терминологии [103]. Можно надеяться, что благодаря вики-технологии такая ситуация не грозит Викисловарю. На 10.11.2007 Викисловарь содержал 130 тыс. слов и словосочетаний более чем на 180 языках.

Вики – это веб-сайт для совместной работы, где каждый может принять участие в правке статей. Вики-сайт предоставляет пользователям возможность изменять и добавлять страницы сайта.5 Наиболее известный вики-ресурс – Википедия.

Ward Cunningham, разработчик первого вики-сайта WikiWikiWeb, первоначально описал вики как «простейшую онлайн базу данных, которая, возможно, работает».6 Также вики – это часть программного обеспечения на стороне сервера, позволяющая пользователям коллективно создавать и редактировать содержания интернет страниц с помощью любого интернет браузера. Язык вики поддерживает гиперссылки (для создания ссылок между вики-страницами) и является более наглядным чем HTML и безопасным (использование JavaScript и Cascading Style Sheets ограничено).7